商机详情 -

天津眼动追踪不准

眼动追踪与阅读行为分析借助眼动追踪技术,研究者能解析读者阅读时的注视模式。实验表明,专业读者在学术文献中的回视次数(重复注视)明显少于新手,且***注视时间更短,这表明眼动追踪可量化阅读技能差异,辅助个性化学习系统开发。眼动追踪与驾驶安全眼动追踪系统被应用于驾驶员状态监测,通过追踪眼球运动实时判断注意力分散程度。当检测到驾驶员长时间未注视前方道路时,系统会触发警报,这种技术已在自动驾驶辅助系统中成为保障行车安全的关键模块。眼动追踪与虚拟现实体验在VR场景中,眼动追踪技术可动态调整画面渲染精度。当用户注视特定区域时,系统自动提升该区域分辨率,而边缘区域则降低渲染负荷,这种“注视点渲染”技术使VR设备在保持画质的同时降低硬件能耗。眼动热力图显示,电商商品详情页中,用户视线在价格区域的停留时间比促销标签长2.3倍,指导页面布局优化。天津眼动追踪不准

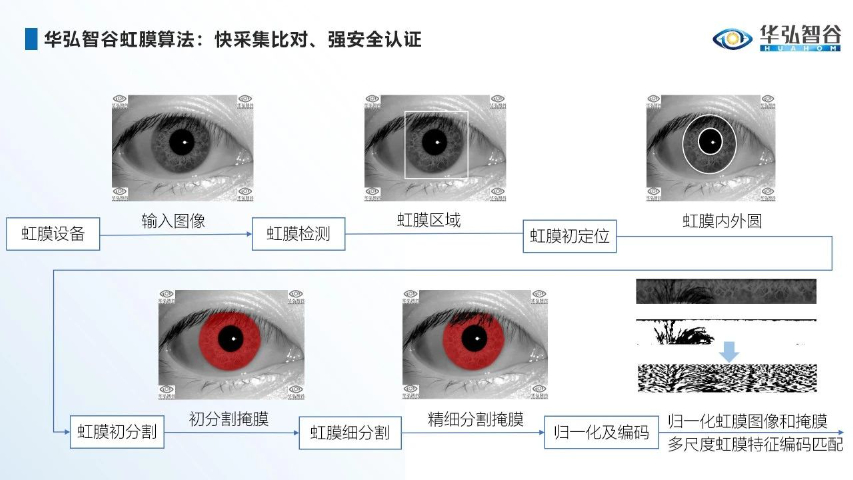

煤矿井口的尘与暗曾是虹膜识别的噩梦,华弘智谷却把“眼动追踪”做成了矿工的安全锁。国家能源集团神东煤矿部署的井口考勤机采用 30-70 cm 宽工作距离模组,矿工戴着防尘眼镜、头灯直射也能在 1 秒内完成虹膜+眼动双重验证:系统先比对虹膜 ID,再追踪眼球微小震颤判断疲劳状态,异常者自动禁止下井并推送预警。目前 6 万名矿工零替打卡事故,井下因疲劳导致的事故率同比下降 18%,眼动追踪从“识身份”升级为“管安全”。金融场景对时延极度敏感,华弘智谷把“眼动追踪”嵌进 ATM 的摄像头里,做成“无感风控”模块。建设银行试点的虹膜 ATM 在 300 台设备上运行:用户插入银行卡后,3 ms 内完成虹膜身份核验,同时在 2 ms 内用眼动追踪检测是否有人偷窥——当检测到第二双眼睛注视屏幕 0.5 秒以上,系统立即暂停交易并语音提示。2024 年试点数据表明,因窥视导致的密码泄露投诉为零,计划 2025 年扩容至 2000 台,眼动追踪成为金融终端的新防火墙贵州眼动追踪眼动追踪技术可用于实现基于眼睛注视的交互方式,如眼控鼠标、眼控键盘等,为特殊人群提供了新的交互手段。

作为国内眼动追踪领域的**企业,华弘智谷已构建从算法研发到量产制造的全链条能力。其自研的“虹膜-眼动”双模芯片采用28nm制程工艺,在0.3mm²面积内集成红外摄像头、虹膜识别模块和眼动追踪处理器,功耗较分立方案降低60%。在供应链端,公司与立讯精密合作开发柔性电路板,使眼动模组重量从12g降至5g,适配AR眼镜等轻量化设备。在生态建设方面,华弘智谷推出OpenEye开发者平台,提供SDK工具包和仿真测试环境,支持第三方应用快速集成眼动功能。目前,该平台已吸引超200家企业入驻,涵盖XR、医疗、教育等12个行业。面向未来,华弘智谷正研发基于事件相机(Event Camera)的下一代眼动技术,其百万帧/秒的采样率将实现微秒级响应,为脑机接口等前沿领域奠定基础。

眼动追踪技术正在重塑我们对阅读理解的认知边界。过去研究阅读障碍时,只能依赖事后问卷,如今通过记录毫秒级的注视、回视与扫视轨迹,科学家得以在读者意识形成前就捕捉其认知负荷的波动。实验显示,当文本出现歧义词时,高阅读能力者的瞳孔扩张幅度比低能力者小42%,而回视路径长度短30%,这说明眼动追踪不仅能验证理论模型,还能实时预警理解失败,为个性化阅读训练提供量化依据。未来教材将嵌入微型眼动仪,根据学生的实时眼跳模式动态调整句法复杂度,使阅读难度始终保持在维果茨基所说的“**近发展区”内,实现真正的因材施教。眼动仪:是实现眼动追踪的关键设备。

在消费级XR设备领域,眼动追踪与注视点渲染技术的融合正重塑用户体验。华弘智谷的虹膜眼动模组采用双目红外摄像头阵列,以120Hz采样率实时追踪用户视线焦点,动态调整虚拟场景渲染分辨率。以Pico Neo 5 Pro为例,搭载该技术后,设备算力需求降低40%,续航时间延长1.5倍,同时通过模拟人眼**凹视觉特性,使画面边缘模糊化处理更符合生理感知。在交互层面,华弘智谷与Unity引擎深度合作,开发出基于视线触发的UI系统——用户*需凝视菜单选项2秒即可完成选择,配合虹膜识别实现无感登录。这种“所见即所选”的模式已应用于工业维修培训场景,学员通过眼动操作分解机械结构,系统根据凝视热点智能推送操作提示,使培训效率提升60%。在线学习平台通过追踪学生注视点分布,发现85%的注意力分散发生在视频讲解的第12-15分钟。四川pro眼动追踪

抑郁症患者执行反扫视任务时,眼动轨迹的规则性指数较健康人群低58%,为早期筛查提供生物标志物。天津眼动追踪不准

眼动追踪技术正在赋能智慧农业的精细化发展。华弘智谷的AgriEye系统通过无人机搭载的多光谱眼动追踪模块,模拟植物学家观察作物的视线轨迹,结合AI图像识别技术量化评估植株健康状态。在山东寿光的蔬菜大棚试点中,系统发现经验丰富的农户在检查番茄病害时,视线会优先聚焦叶片背面和茎秆分叉处,且对黄化曲叶病毒的典型症状(叶片卷曲、颜色深浅不均)的凝视热点分布与实验室检测结果高度吻合。基于此,AgriEye系统开发了“**视线模型”,通过训练神经网络学习农户的观察路径,使AI病害识别的准确率从78%提升至92%。此外,该系统还可分析蜜蜂采蜜时的飞行轨迹,通过眼动级精度的运动追踪,优化果园授粉树种的布局,使苹果坐果率提升18%。天津眼动追踪不准